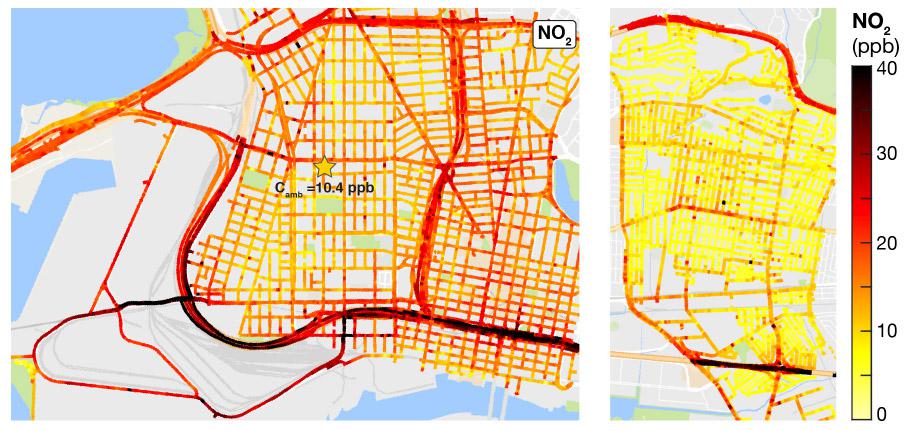

Mappatura dello smog rilevato tramite le auto di Google Street view[/caption]

Integrando i dati con quelli delle normali centraline a postazione fissa, si aprono dunque nuovi scenari di ricerca per la ricostruzione spaziale modellistica degli inquinanti e, di conseguenza, per le indagini epidemiologiche. Tali studi permetteranno di conoscere la reale esposizione della popolazione allo smog in ambienti urbani e di valutare molto più precisamente le correlazioni tra questa e i danni alla salute.

E il merito è soprattutto dei cosiddetti big data. L’era moderna, caratterizzata dalla logica binaria dei computer e dall’aumento esponenziale della capacità di memorizzazione dei dati, ha posto le basi per questo nuovo tipo di dato sperimentale, capace di nascondere un’informazione differente da quella strettamente scientifica. Innanzitutto, il numero dei casi osservabili è incredibilmente elevato. Oggi è possibile accedere, e quindi elaborare, a 2 terabyte di informazione in pochi secondi: un calcolo inimmaginabile fino a non molti anni fa. L’altro fattore chiave è la quantità di variabili che possono essere memorizzate contemporaneamente.

I big data non necessariamente soddisfano leggi della natura e questo aspetto è di rilevanza cruciale: se da una parte la mancanza di una legge generale che li governi rappresenta una limitazione perché introduce una nuova complessità, dall'altra si apre un nuovo mondo per la ricerca. Quello della scoperta di possibili relazioni fra variabili non strettamente legate a leggi di conservazione o ad altri vincoli imposti dalla natura.

Armando Pelliccioni è un fisico teorico. Si occupa, tra i vari temi, di intelligenza artificiale e modelli matematici applicati all’ambiente

Mappatura dello smog rilevato tramite le auto di Google Street view[/caption]

Integrando i dati con quelli delle normali centraline a postazione fissa, si aprono dunque nuovi scenari di ricerca per la ricostruzione spaziale modellistica degli inquinanti e, di conseguenza, per le indagini epidemiologiche. Tali studi permetteranno di conoscere la reale esposizione della popolazione allo smog in ambienti urbani e di valutare molto più precisamente le correlazioni tra questa e i danni alla salute.

E il merito è soprattutto dei cosiddetti big data. L’era moderna, caratterizzata dalla logica binaria dei computer e dall’aumento esponenziale della capacità di memorizzazione dei dati, ha posto le basi per questo nuovo tipo di dato sperimentale, capace di nascondere un’informazione differente da quella strettamente scientifica. Innanzitutto, il numero dei casi osservabili è incredibilmente elevato. Oggi è possibile accedere, e quindi elaborare, a 2 terabyte di informazione in pochi secondi: un calcolo inimmaginabile fino a non molti anni fa. L’altro fattore chiave è la quantità di variabili che possono essere memorizzate contemporaneamente.

I big data non necessariamente soddisfano leggi della natura e questo aspetto è di rilevanza cruciale: se da una parte la mancanza di una legge generale che li governi rappresenta una limitazione perché introduce una nuova complessità, dall'altra si apre un nuovo mondo per la ricerca. Quello della scoperta di possibili relazioni fra variabili non strettamente legate a leggi di conservazione o ad altri vincoli imposti dalla natura.

Armando Pelliccioni è un fisico teorico. Si occupa, tra i vari temi, di intelligenza artificiale e modelli matematici applicati all’ambienteLe mappe digitali di Google sono da tempo la bussola che guida quotidianamente milioni di utenti per le vie delle città di tutto il mondo. Tra i vari dati che il colosso di Mountain View usa per integrare le sue cartografie, insieme a foto satellitari e immagini tridimensionali delle strade, ci sono anche quelli legati allo smog. Primo esperimento a Oakland, in California, grazie a rilevatori di particelle inquinanti installati sulle auto che battono le metropoli, strada per strada, per raccogliere le immagini di Google Street view. E ora, la gigantesca mole di rilevazioni, in termine tecnico big data, permette di aprire frontiere scientifiche ancora inesplorate.

Per capire il perché, occorre fare un piccolo passo indietro.

La risposta all’inquinamento atmosferico passa necessariamente per la modellistica ambientale, ossia la capacità di calcolare matematicamente i livelli di smog nello spazio-tempo. Fino ad ora, tali ricostruzioni potevano essere fatte in due modi: elaborando i dati delle centraline di monitoraggio per poi approssimare l’inquinamento in altri punti tramite modelli statistici (ad esempio, i cosiddetti Land use regression model, “Lur”), oppure rifacendosi a modelli di dispersione, che usano come dati di ingresso le previsioni meteo, la stima delle principali sorgenti e le equazioni del trasposto per poter mappare gli agenti inquinanti nelle città. Attualmente non ci sono evidenze chiare su quale approccio sia il migliore, anche se la modellistica previsionale offre degli indiscutibili vantaggi rispetto agli approcci statici, come quello di poter simulare fenomeni fisici.

Ma a sparigliare le carte, a giugno di quest’anno, sulla rivista Envirnomental science & technology, è uscito l’articolo “High-resolution air pollution mapping with Google Street view vars: exploiting big data”, nel quale sono presentati i primi risultati di uno studio pilota portato avanti da alcune università americane ed enti di ricerca relativamente all’esposizione di pericolosi inquinanti come monossido e biossido di azoto, per la città di Oakland in California.

L’articolo apre a una nuova metodologia per il monitoraggio ambientale nelle città. I big data ambientali sono forniti da Google che ha lanciato una nuova funzione di Street view, grazie a due autovetture equipaggiate con sensori di qualità dell’aria ad alta risoluzione temporale. Questa permette un monitoraggio dinamico per ampie porzioni di città, con postazioni mobili georeferite.

Integrando i dati con quelli delle normali centraline a postazione fissa, si aprono dunque nuovi scenari di ricerca per la ricostruzione spaziale modellistica degli inquinanti e, di conseguenza, per le indagini epidemiologiche. Tali studi permetteranno di conoscere la reale esposizione della popolazione allo smog in ambienti urbani e di valutare molto più precisamente le correlazioni tra questa e i danni alla salute.

E il merito è soprattutto dei cosiddetti big data. L’era moderna, caratterizzata dalla logica binaria dei computer e dall’aumento esponenziale della capacità di memorizzazione dei dati, ha posto le basi per questo nuovo tipo di dato sperimentale, capace di nascondere un’informazione differente da quella strettamente scientifica. Innanzitutto, il numero dei casi osservabili è incredibilmente elevato. Oggi è possibile accedere, e quindi elaborare, a 2 terabyte di informazione in pochi secondi: un calcolo inimmaginabile fino a non molti anni fa. L’altro fattore chiave è la quantità di variabili che possono essere memorizzate contemporaneamente.

I big data non necessariamente soddisfano leggi della natura e questo aspetto è di rilevanza cruciale: se da una parte la mancanza di una legge generale che li governi rappresenta una limitazione perché introduce una nuova complessità, dall’altra si apre un nuovo mondo per la ricerca. Quello della scoperta di possibili relazioni fra variabili non strettamente legate a leggi di conservazione o ad altri vincoli imposti dalla natura.

Armando Pelliccioni è un fisico teorico. Si occupa, tra i vari temi, di intelligenza artificiale e modelli matematici applicati all’ambiente